昨天下午有去参加一场线下活动,相互之间交流下 AI 在实际工作场景下的应用。恰好这个点与我最近一年多的实践很相关,干脆展开聊聊。

我记得去年年初看过一位国外博主分享的,利用 N8N 与 AI 能力去全自动运营网站的视频,当时就感觉发现了新大陆一样。

毕竟对比我自己的手动运营流程,他分享的那套东西不仅效率很高,而且在完善 SOP 的情况下,能较少出错。所以当时也下定了决心要将这套流程实现出来,并应用到我自己的工作中去。

但这件事没那么容易的,对于我而言困难有两点。

首先是技术这块的问题就不那么容易解决,毕竟我自己已经很久没有碰技术了,能力实在有点菜。

其次就是没有完整的头绪,因为这件事之前没有做过,仅仅只是看了一个视频,还是不知道从哪里下手。

所以当时也是一个人在慢慢摸索,就想着先从一个一个的小流程做起,一个一个进行优化。先不追求把整个系统全部做完,而是把频繁接触到的工作流程尝试着实现出来。

我记得最先做的流程是搜索结果页面信息的调研,通过输入一个词根,然后不断挖掘页面上信息。通过这种信息的深度挖掘来输出相应的调研报告,从而节省点自己平时在这上面花费的时间。

说实话刚开始做出来的这个版本,一点都不好用,远不及自己亲自去看调研结果来的踏实。因为我觉得这种涉及到经验判断的流程,需要个人的主观意识,而这部分内容没办法被自动化程序替代(可能这也是人的价值所在)。

于是在这次之后,就开始尝试着换个思路。AI 与自动化流程只协助我处理重复劳动与简单操作,而一些调研类、分析类的工作全部用人工亲自去做,程序只用于辅助提升效率。

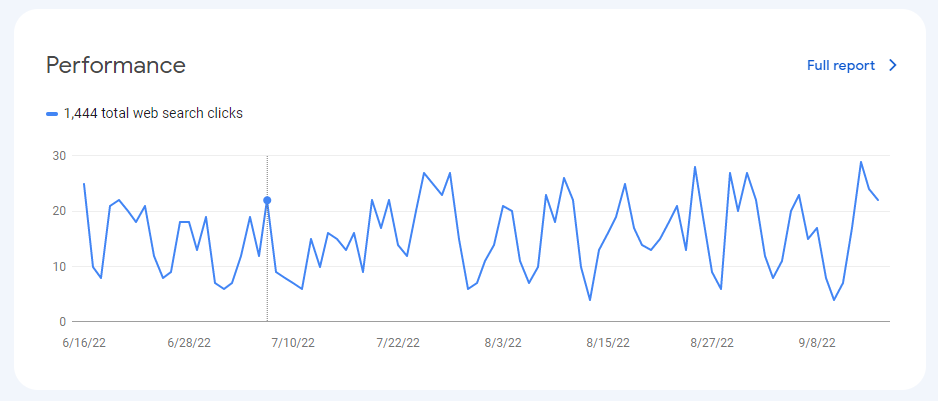

如此经过大半年吧,算是将全部的小流程实现完了,且上个月算是将这些小流程之间的协同全部打通。

逻辑一点都不高大上,就是找一个数据协同工具(我们团队一直使用的是 Gsheet),然后将不同工具、不同流程融合进来。

比如就很多朋友喜欢的文案生成流程,我们的做法就分三步。

先建立数据表格并利用自动化程序抓取对应素材,自动保存到表格中。这一步做完之后,我们人工会去检查下数据是否抓取完整,有没有程序出错。

一切顺利的话,直接在 Gsheet 里面利用 AI 能力去做数据清洗与格式化。这比较简单,写个自定义函数就能搞定了。

最后就涉及到文案的生成了,这一步倒是最简单的。因为数据格式化已经处理好了,剩下的就是将这些数据组装成一个 Prompt 并发送给 AI,并将 AI 返回给我的信息保存下来。

机器做完这些自动化的流程后,剩下就是人工去做事实核查与文案修改与调整了。而这种动作需要个人的经验加持,程序永远没能力做。

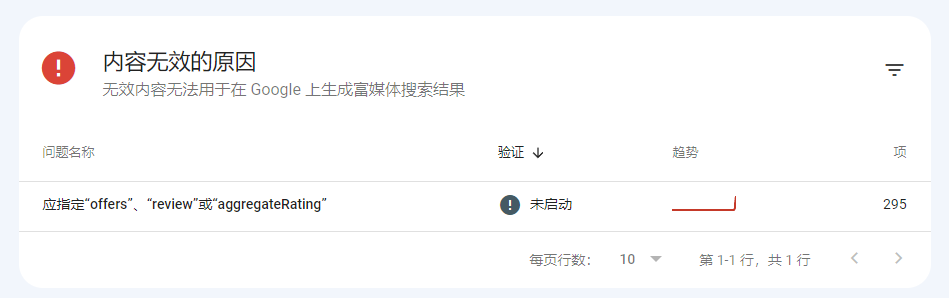

当人工做完审核与修改,达到上线标准后,直接单击下『上传』按钮,于是内容便部署到自己的网站了。

其实类似上面这样的小流程还有很多,而做完这些流程优化之后,给我最直接的反馈就是工作的效率更快了,大白话说就是一个人做十个人的活(一点不夸张)。

当然后续如果有新的技术栈出现,或者有新的需求出现,完全可以利用现在的思路将其并到我自己的工作流中去。