这周一直在做些年底收尾相关工作,忙完就准备过年放假了,分享下工作中发现的新问题。

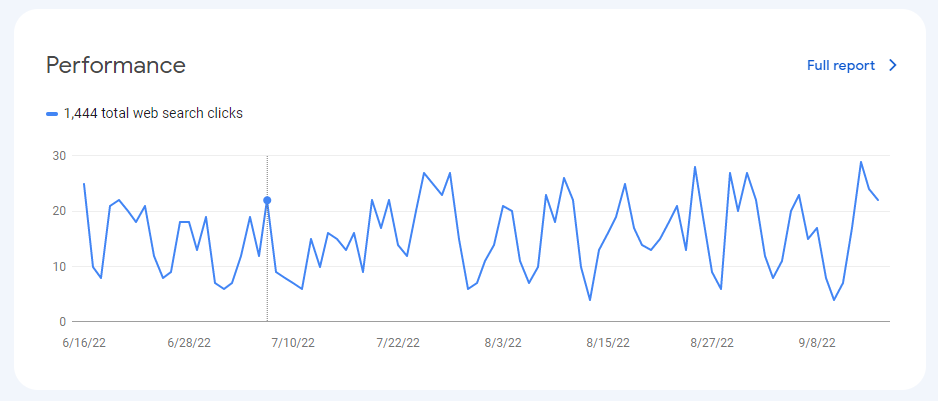

上次 CloudCone 宕机导致我部署的两台 Umami 数据跟踪服务挂了,这段时间网站的数据跟踪就一直没处理,过程中也开始考虑不同类型的网站到底该使用什么样的跟踪服务。

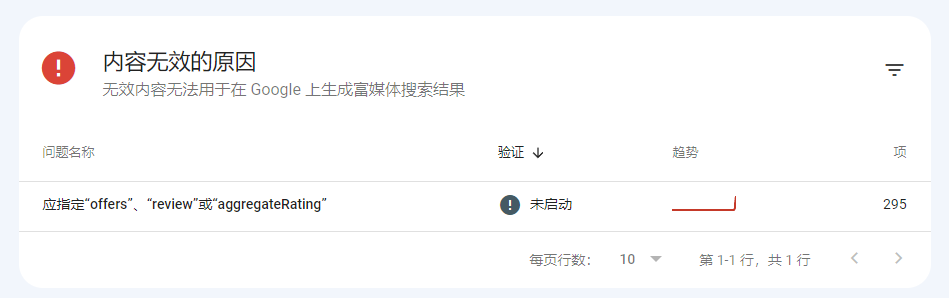

像电商这种类型的站点,如果认真实操起来会发现需要跟踪的事件点会非常多,而这类新型跟踪服务处理这类电商事件的跟踪会比较吃力。

还得看老牌谷歌分析配合他们的标签管理,才可以很方便将这部分数据监控起来。

但这部分内容我之前一直没有深入研究,只是泛泛会一些基础使用,尤其是自定义数据跟踪与自定义数据报表呈现这块,我过去就没实际操作过。

后面的想法是,拿一个用户活跃站点实操下全流程增强型电商的用户行为跟踪(这套方案需要写不少脚本代码),趁着这样的机会将这套逻辑沉淀下来,也学习下这里面的具体分析思路。

我觉得这种从用户行为数据出发去做优化的思路,肯定是没问题的,尤其是购买决策行为的跟踪,能从中发现不少有意思的点。

除了数据跟踪这个点值得后续投入精力优化之外,还有一个经常谈及的点就是 AI 介入。

这段时间在重新审视过去自己写的一些工作流程,发现还是有点保守且不够聪明。

过去我的思路是,只让 AI 去做那些重复且繁杂的工作(主要目的是节省人力),至于逻辑判断或者需要一点点选择类的内容则完全不让 AI 参与其中。

在这种思路下开发出来的 AI 工作流程,做起事情来确实很稳当,但是缺点也非常明显,就是一旦涉及到需要抉择的工作流程就需要人工干预。

可能这个事情完全交给 AI 做,它处理一百次会有概率出现五次左右的错误,但是我之前的保守思路,单纯为了规避这几次错误而牺牲掉整个流程的流畅度,且还投入不少人力。

所以假期这段时间,我会花时间重新审视下自己工作流中的具体场景,打算换个思路重新来一遍。

将之前的事前控制逻辑改成事后检查逻辑,也就是所有的工作内容都放手让 AI 去做,我自己则尽可能做好案例库与各种行为控制,尽最大努力去降低 AI 出错的概率。

那等 AI 做完之后再投入精力去检查 AI 到底做得怎么样,看看其输出的质量是不是符合我们的要求。

甚至这套检查流程也可以用不同的 AI 模型去做(类似于三步翻译的逻辑),直接给定明确的标准让其检查是否合格并输出具体的检查结论即可。

其实这套逻辑 24 年有朋友跟我分享过,还记得我们当时是在讨论一个数据清洗场景下的算法逻辑问题,但当时我没有放在心上,更没有联想到现在这种工作场景。

所以现在等问题真正呈现在自己眼前,查阅很多资料之后再回想起来才会突然醒悟过来。