我之前分享过自己做网站内链的一些思路,总结起来其实很简单。

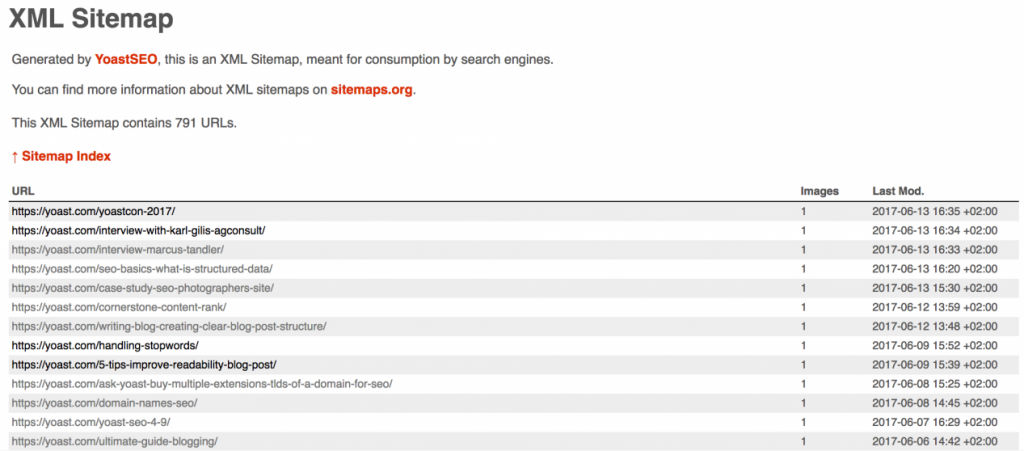

首先将网站的 GSC 出词数据全部收集起来,然后将页面上的文案内容全部整理下来,将这两份数据放到 Excel 表格中。

然后再使用公式,去标记这些内容在哪些文案中出现过。对于那些出现过的关键词,再自己去人工核查一下,并顺便去做一条内部链接。

当然过程中得遵循内链的一些基本原则,像一个关键词最好只对应一个页面,避免出现「一对多」这种情况。

其实这套模式我自己是一直有在工作环境中使用的,但是最近我想把这套体系升级一下,将 AI 的能力引进来,实现更方便,或者说更全面的内链创建。

至于升级的点,主要还是为了优化现有这套方案的弊端。

比如现在这套方案,如果 GSC 报表里没有出词,那这套体系就没办法使用。但是你我都知道,在网站搭建初期,肯定是有一些关键词适合做内部链接的。

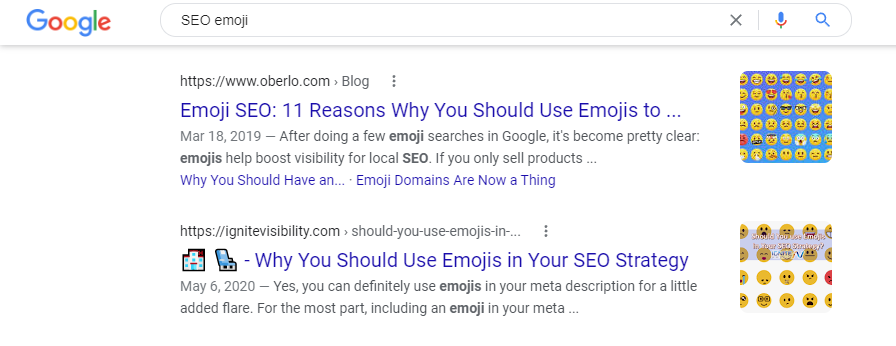

其次就是 GSC 的出词毕竟有限度,如果我们有意图引导 GSC 出词,还是有必要去做一些前期的“埋词”操作。

正是基于上面的几点不足吧,所以我下一步打算在现有基础上升级下,自己在用的这套内链方案。

比如将两部分数据整理完后,全部扔给 AI,让 AI 工具给出相应的关键词建议,或者是相关关键词变体建议。甚至可以的话,直接让 AI 给我详细的内链操作步骤。

其实新升级的这些思路,实际操作起来并不难。但可能存在一个比较尴尬的点,就是当内容足够大之后,相应的 AI 模型消化不过来。

甚至,当投喂的内容量足够多时,相应模型的 API 成本也会蹭蹭蹭往上升。

所以这几天也一直在思考更敏捷的一些方案,可能的话在本地机器上部署个开源的 AI 模型跑起来,试试具体操作后看看实际效果。

甚至我在考虑要不要将这套模式,做得更自动一些,抛弃之前使用的 Excel 方案,转而使用一些自动化程度更高的方案。

后面实操下,看看具体什么方案比较合适。