我自己有几个新站点的索引比较有意思,这篇文章单独聊聊这个点。

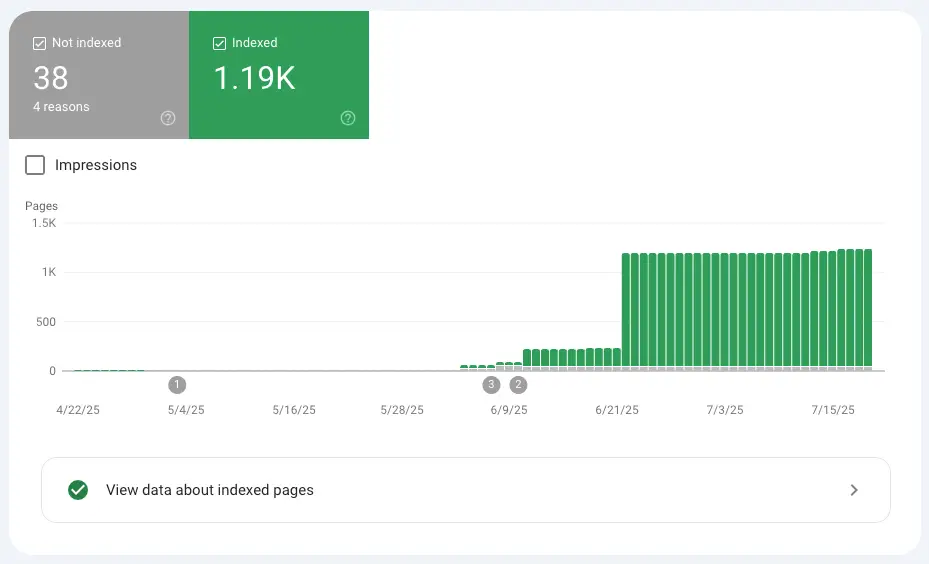

一个网站只要上传内容,基本隔天都能自动收录好,出词这块的数据都还不错。另一个则刚好相反,上传什么类型的内容都不收录,即便手动提交收录也都没有任何反应。

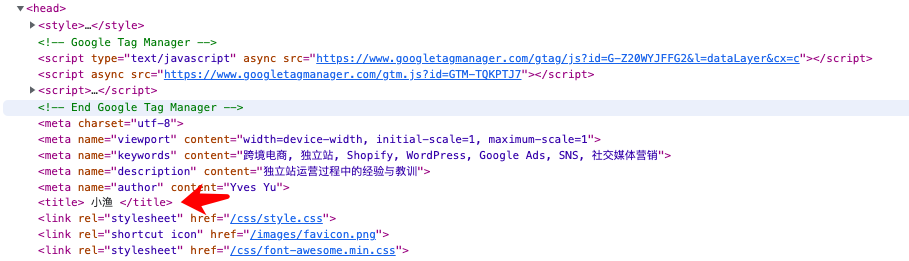

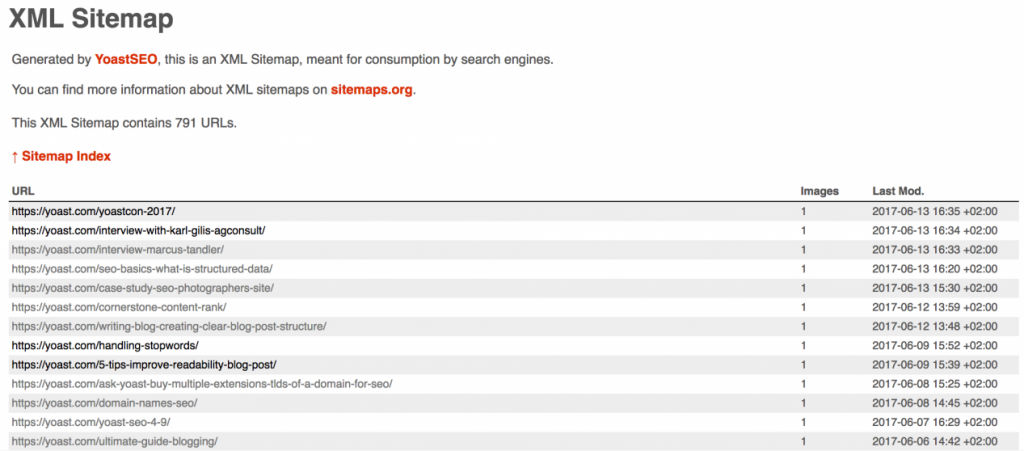

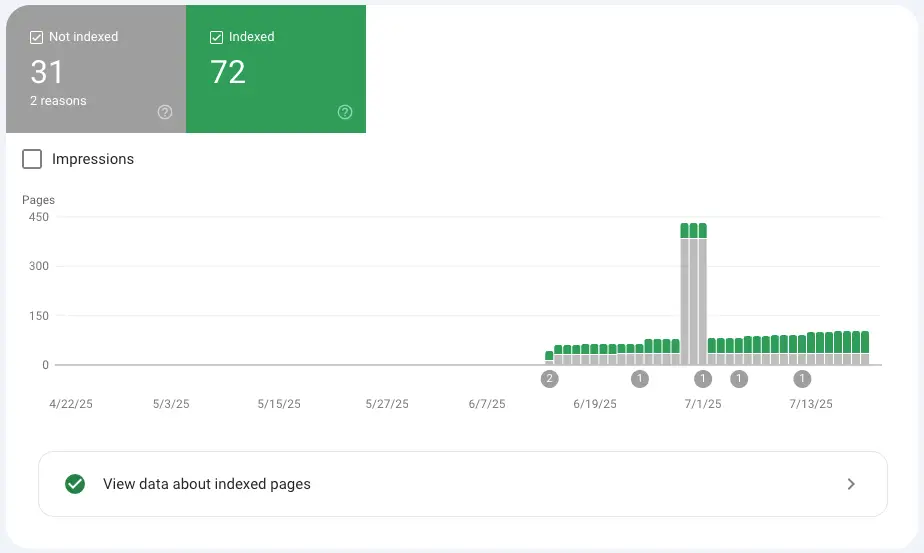

比如上面第一张图便是收录比较好的网站,而第二张图片则是收录比较糟糕的(实际的链接数量要远远多于这个数)。

所以这段时间我一直在关注这方面的信息,尤其是最近的六月算法更新,我就想弄明白收录系统的最新工作逻辑是什么。

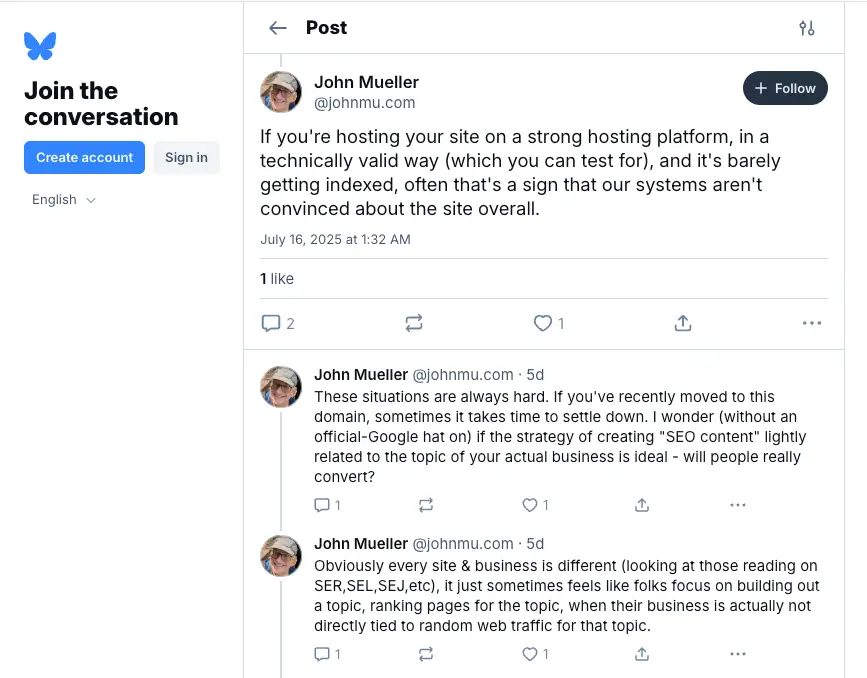

恰好上周看到 John Mueller 在社媒平台上发布的这条帖子信息,可能一定程度上解释了索引系统工作的新逻辑。

原文是:If you’re hosting your site on a strong hosting platform, in a technically valid way (which you can test for), and it’s barely getting indexed, often that’s a sign that our systems aren’t convinced about the site overall.

大意就是:如果你的网站在技术设置这块没有任何问题,但仍是收录不好,则有可能是你的网站内容没办法获得搜索引擎的信任。

归根到底还是内容的问题,说实话这个点我自己都不知道怎么解决。

就拿我上面列出的两个站点而言,都是同样的调研流程、同样的建站方式,甚至是同样的内容生产流程做出来的。

把这两个网站放在一起比较,唯一不同的可能就是上面的文案信息与图片(毕竟做的是不同的产品)。但没办法,两个网站收录情况就是截然不同。

而且 John Mueller 在上面的帖子里还分享了几个点。

If you find yourself needing to often submit your URLs to the index manually, that can be a sign of quality issues.

Low quality content that is not indexed is not surprising to Googlers.

Pages that may be deindexed, may be deindexed over quality issues.

我觉得上面的内容中,除了老生常谈的低质量内容之外,还有个点值的注意。那就是经常主动提交链接给搜索引擎收录,这在搜索引擎看来可能是内容质量低下的信号。

是不是跟我们的常规认知有点区别,毕竟我们过去的常规做法是,上传完内容之后立马就主动提交链接给搜索引擎收录,甚至之前我们甚至使用 API 进行链接的批量提交。

只是去年年底 API 批量提交方式被谷歌明确禁止之后,外加 GSC 后台主动提交的次数额度有很低的限制,我自己就再也没做链接的主动提交收录了。

所以现在还是静观其变吧,对于链接收录还可以的站点,继续保持这样的节奏去做。至于收录不理想的站点,放着观察吧,可能在这种状态下继续上传内容,大概率也不会被收录,甚至还有害。

或者对于这些收录不理想的站点,我们可以尝试着曲线救援策略。尝试着做一些站外推广,通过提升网站的品牌曝光概率,从而吸引搜索引擎对我们站点的重新评估。

没办法,现在只能是多测试多积累数据,现在搜索更新的频率相较于前几年实在是频繁了很多。